人工知能とはどのような存在で、どこに向かうのか―米国人専門家が紹介

拡大

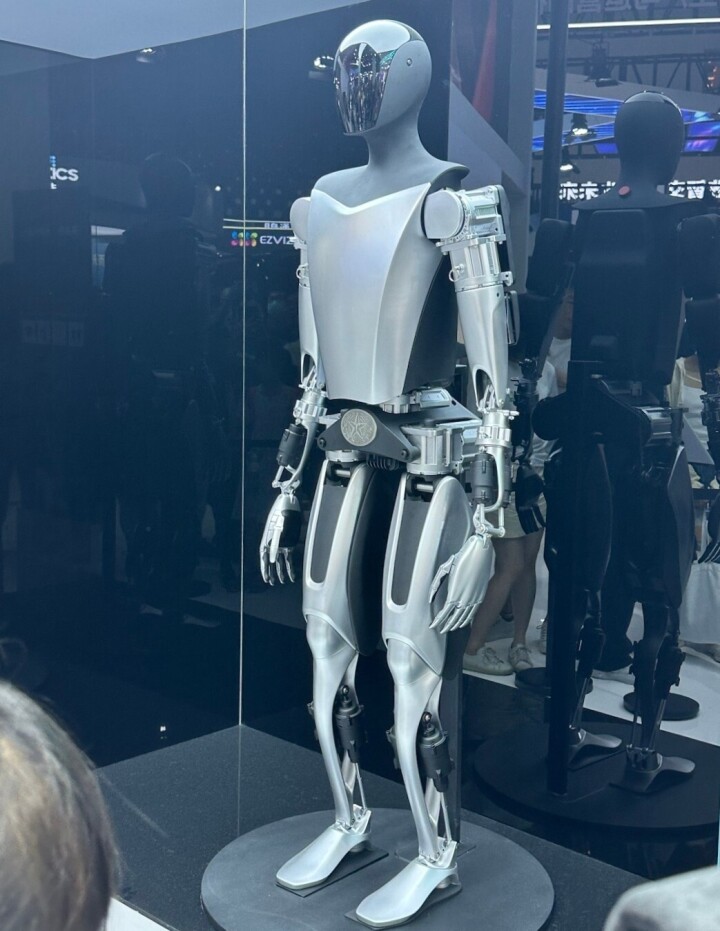

人工知能の本質とは何なのだろう。世界をどのように変えるのだろう。写真は上海市内で開催された「2023世界AI大会」で披露されたAI機能を搭載したテスラの「オプティマス」。

このところ人工知能(AI))に対する関心が高まっている。AIは、これからますます産業や社会で決定的な役割りを果たすとされる。AIに何を期待できるのか、逆にAIの危険性はどこに潜むのか。中国メディアの中国新聞社はこのほど、カリフォルニア工科大学のヤセル・アブ・モスタファ教授を取材して、AIについていろいろと質問した。モスタファ教授はエジプト系米国人で、コンピューターサイエンスの専門家として著名な存在だ。以下はモスタファ教授による説明の主要部分に若干の内容を追加するなどで再構成したものだ。

イーロン・マスクの懸念は感情的で実情と乖離

米実業家のイーロン・マスク氏らはこの春、強力なAIの開発を6カ月停止することを求める連名の公開書簡を発表した。意図は良いと思うが、研究開発の6カ月停止を順守する企業はいないので、現実的な効果はない。この動きは、AIが「急成長しすぎている」ことへの無意識の反応であり、深く考えられた行為ではないと思う。私個人としては、強力なAIモデルの研究開発を一時停止することには賛同できない。今やるべきことは一時停止ではなく、いかにしてその「悪しき使用」を食い止めるかだ。だから私は公開書簡に署名しなかった。

AIをより強力に監督するにはどうすればよいのか。政府はAIの利用を、法的措置を含めて制限する必要がある。欧州連合(EU)のAI法案はその端緒だ。法律は、AIへの恐怖や想像上のリスクに対処するために急いで制定されるのではなく、慎重に検討されなければならない。今のところ、熟慮され効果的に実行されている提案や法規は見られない。

AIを人間の価値観や道徳規範に真に合致させることは、ひとえにAIシステムの開発者と利用者にかかっている。AIに道徳感や悪意はなく、命令に従い、訓練されたことを実行するだけだ。人が偏見に満ちたデータを与えれば、偏見に満ちたAIが誕生する。そのためChatGPTなどの開発を手掛けるOpenAIは、良いデータを選んだりChatGPTが悪意ある質問に答えないように調整し続ける必要がある。

問題を複雑にしているのは、開発者がシステム全体を「人としての価値観に適合する」ように設計しても、さまざまな方向性でAIを使う人が出てくることだ。開発者は利用者をコントロールできない。そのため、AIについては、設計よりも応用の方がはるかに複雑で危険だ。

人間社会で善し悪しの基準は明確でない。AlphaGoのようなゲーム用AIならば「よい行為」を上手に定義できる。ルールに従って勝つことができれば、それが「よい行為」だ。しかし、良いと悪いを判断する客観的なルールが不足する状況でAIを訓練し、システム自身に「良い行動」とは何かを理解させることは非常に難しい。

マスク氏らの公開書簡は「制御不能な競争」という感情的な表現を使った。しかし、近い将来のAI産業では、非常に強力な2、3種のAIツールが世界市場を寡占する可能性が高い。なぜなら、開発に莫大なコストがかかるからだ。現在の最新のビッグモデルAIの進展はすべて、大学ではなく企業からもたらされているのもそのためだ。

もし今後、革新的な計算方法の出現などでコストを10億ドル(約1400億円)から1000万ドル(約14億円)に下げることができる斬新なモデルが登場すれば、その時点で多くの開発者が参画することになるだろう。

AIは「意識を持っているように見える」ようにはなる

私のある友人がChatGPTに「アブ・ムスタファについて、何を知っていますか?」と尋ねた。ChatGPTは私に関する詳細な経歴と人物の小伝をリストアップした。最初の部分は非常に専門的に見えるが、次の部分では単純なミス、例えば私の大学を間違えるなどが多かった。これはChatGPTの本質をよく示している。つまり、ある意味では、すべての情報を相互に関連づける特殊な方法でまとめているだけだ。

現在はAIの発展が人々を興奮させている。しかし業界内でも、本当にすべての技術の詳細を理解している人は少ない。OpenAIやGoogleなどでビッグモデルのトレーニングに参加している人だけがはっきりと理解している。しかし彼らの外部との情報共有は限られている。

AIについては、「常識の獲得」や「自己反省の能力」についても関心がもたれている。AIが自己反省能力を発達させるとすれば、それは膨大な訓練がもたらしたものであり、十分な数の「分散して断片的なスマートタスク」を統合することで実現するに違いない。例えば1000個のChatGPTを作って、このうちの一つは言語に興味を持たせ、一つは数学の問題を処理し、一つは視覚認識を担当し……。その「能力」が人間の知的関心のほぼすべての領域をカバーし、さらに一つに統合するならば、必ず「汎用的な知能」を表現できるというのが「マルチモーダル機械学習」の本質だ。

しかしそれは表面上のことであり、自己反省力や汎用知能を備えているように見えるだけだ。ある意味でその巨大システムは「外観」を模倣するだけだ。

問題の鍵は、「汎用人工知能」(AGI)とはそもそも何なのかということだ。AGIの概念について合意を形成し、それを正確なコンピューター言語で定義し、明確な検証ルールを策定する必要がある。明確な検証ルールがあれば、AGIが出現したのかどうか判断でき、潜在的な危険は何かを判断できる。

人間がなぜAGIに関心を持つのかというと、AGI人間性の根本である「自我」の領域に侵入し、「人は唯一無二の存在」という状況を打破するように思えるからだ。そのためAGIを語る場合に、人はあまりにも多くの感情を掻き立てられ、場合によっては非現実的な期待や恐怖を覚える。

しかし、その恐怖は知能と自我を混同している。人々は冷静になになる必要がある。私はAI分野のいかなる技術進歩も「意識的な実体」、すなわち自我を生み出すことはできないと思う。AIは将来、「感情や意識を持っているように見える」ようになるだろう。しかし人間の意識の定義は科学の立場からすれば不確かであり、客観的な測定は不可能だ。

AIの本質は「歯車で動くからくり」と同じ

私は自分に意識があることを分かっている。あなたも同様だ。では愛とは何か、感情とは何か、悲しみとは何か。私もあなたもそれらを感じることはできる。感情を結び付けることができる。しかし、これらはすべて人としての経験だ。われわれは、なぜそうなったのかを知らない。

AIは常に無生物の機械だ。電子的に構成されてはいるが、複雑で精密な歯車によって動くからくり仕掛けと同様だ。複雑なアウトプットにより「そこに奇妙な人がいる」という印象を受けるかもしれないが、そのアウトプットは意識により生じたものではなく、アルゴリズムによるものだ。

ではなぜ、AIは人と同様な感情を持っていると思えてしまうのか。それは人の判断の方法による。人が知覚するのは、対象が何であれアウトプットだ。人はそのアウトプットを自らの脳内で過去の記憶や感情などと結びつけて判断するからだ。だから、人と同様のアウトプットをするAIがあれば、そのAIが意識や感情を持つように思えてしまう。

今後はあらゆる業界が、予想もできない形でAIの発展の恩恵を受けることになるだろう。私は5年前に、AIは20年以内に人の通常の知的作業のほぼすべて、つまり「複雑な作業をこなすが創造は必要としない知能」に取って代わると言った。自動運転はその典型例だ。

AIが創造力を発揮するようになるかどうかは、単純な問題ではない。例えばAlphaGoの場合、試合に勝つために、人間が想定していなかった防御策を発見する。これが創造なのか、単なる自動化の産物なのかは分からない。少なくともAIは膨大な数の戦略を頃見ている。現時点では「AIの創造性」をきちんと定義することは出来ない。

ただし、AIと共存することにプレッシャーを感じる必要はない。AIは永遠に人類の付属品だからだ。(構成 / 如月隼人)

関連記事

日本の大学生が自殺しようとした理由、中国で大反響=「本当にショッキング」「悲しい、でも…」

Record China

2023/7/31

日本の半導体輸出規制開始、「北京は不満、東京は不安」と独メディア

Record China

2023/7/26

自動運転全プロセス開発プラットフォームを発表、提携会社が改めて追加―ファーウェイ

Record China

2023/7/25

米議会の「対中委員会」がまた何かしでかした!―中国メディア

Record China

2023/7/24

15分で「もう一人の私」誕生?ロボット応用市場に大きな可能性―中国メディア

人民網日本語版

2023/7/24

米半導体業界、政府にさらなる対中規制を控えるよう要請―独メディア

Record China

2023/7/19